Die Technische Universität Krakau (PK) arbeitet an einem Deepfakes-Detektor für Video-, Audio- und Bildinhalte. Krakauer Wissenschaftler wollen mit ihren eigenen Waffen — modernen Techniken, die auf neuronalen Netzen und Deep-Learning-Methoden basieren — gegen Deepfakes vorgehen.

Die Arbeiten an dem Projekt mit dem Titel „Erkennung von manipulierten Audio-Video-Inhalten zum Schutz vor der Verbreitung von gefälschten Nachrichten” werden im Rahmen des ersten Wettbewerbs „Infostrateg” des Nationalen Zentrums für Forschung und Entwicklung durchgeführt. Ein Team der Wissenschaftler von der Technischen Universität Krakau hat Mittel in Höhe von fast 4 Millionen PLN erhalten.

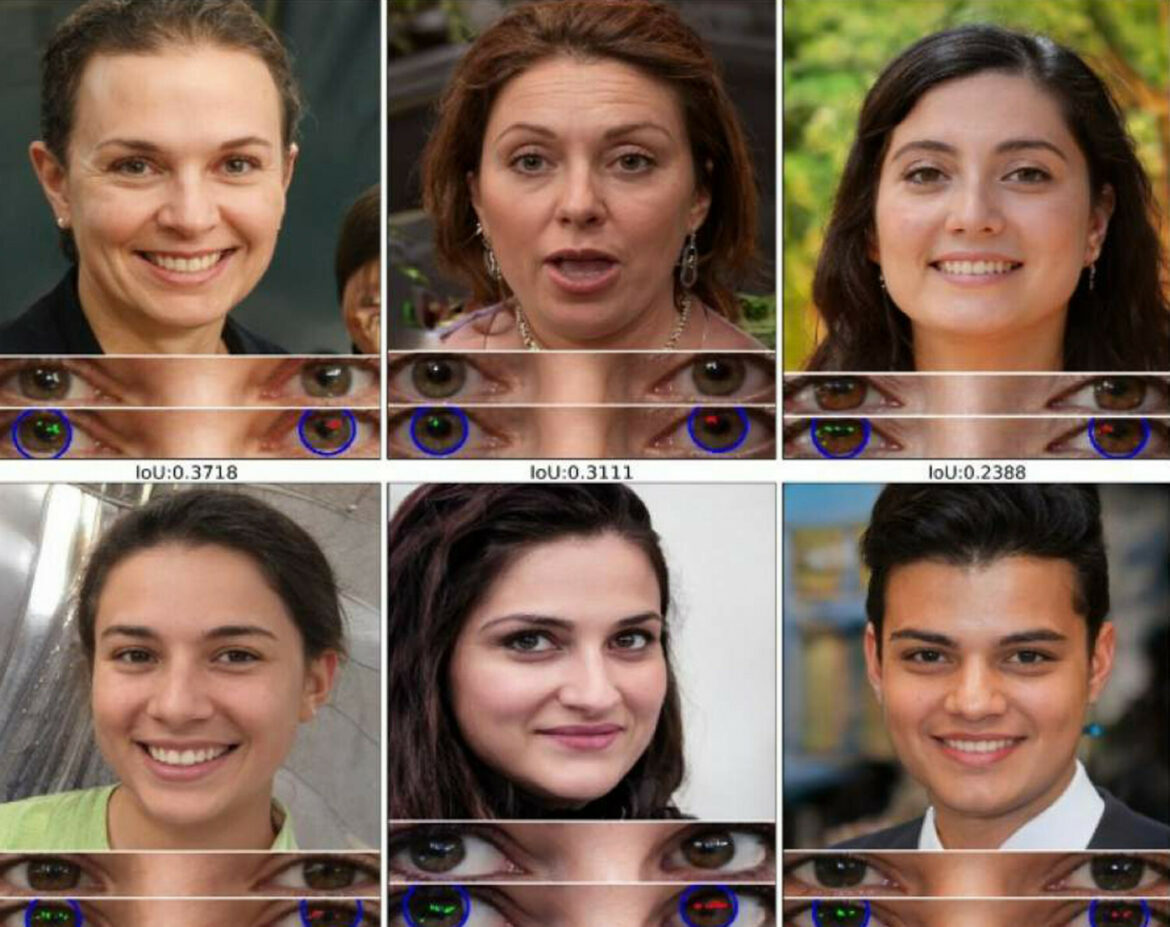

Wir gehen davon aus, dass dieselben oder verwandte Methoden des maschinellen Lernens, die zur Erstellung von Deepfake-Inhalten verwendet werden, auch zur Erkennung manipulierter Inhalte eingesetzt werden können — erklärt Projektleiter Dr. habil. Ing. Michał Bereta, Univ.-Prof., von der Fakultät für Informatik und Telekommunikation der Technischen Universität Krakau.

Das Endergebnis der Arbeit seines Teams wird ein automatisches System zur Überprüfung von Bild-, Ton- und Videoinhalten sein, das unter anderem von Medienmitarbeitern, Redaktionen, PR-Agenturen und anderen Einrichtungen, die das Image ihrer Kunden und Produkte schützen, Internet- und Social-Networking-Sites, der Polizei und anderen Sicherheitsdiensten, Nichtregierungsorganisationen und allen, die an der Überprüfung der Glaubwürdigkeit von Inhalten interessiert sind, genutzt werden kann.

Forscher der Technischen Universität Krakau prognostizieren, dass — ähnlich wie es ein ständiges Wettrüsten zwischen den Entwicklern von Computerviren und den Autoren von Antivirensoftware gibt — eine ähnliche Situation zwischen den Entwicklern von Deepfake-Materialien und den Forschern auf dem Gebiet der neuronalen Netze und des evolutionären Computings entstehen wird, die versuchen werden, die bestmöglichen Methoden zu deren Erkennung zu entwickeln.

Das Auftauchen bekannter Fälle in den Medien, in denen versucht wurde, gefälschtes Material für politische Kämpfe, Verleumdung oder Betrug zu verwenden, macht unser Projekt auf dem Markt noch begehrenswerter — meint Prof. Michał Bereta.

Adrian Andrzejewski